大型网站架构系列:负载均衡详解

[深度学习]读书学习路线

Deep Learning Papers Reading Roadmap

If you are a newcomer to the Deep Learning area, the first question you may have is "Which paper should I start reading from?" Here is a reading roadmap of Deep Learning papers!The roadmap is constructed in accordance with the following four guidelines:

- From outline to detail

- From old to state-of-the-art

- from generic to specific areas

- focus on state-of-the-art

1 Deep Learning History and Basics

1.0 Book

[0] Bengio, Yoshua, Ian J. Goodfellow, and Aaron Courville. "Deep learning." An MIT Press book. (2015). [pdf] (Deep Learning Bible, you can read this book while reading following papers.) ⭐️⭐️⭐️⭐️⭐️1.1 Survey

[1] LeCun, Yann, Yoshua Bengio, and Geoffrey Hinton. "Deep learning." Nature 521.7553 (2015): 436-444. [pdf](Three Giants' Survey) ⭐️⭐️⭐️⭐️⭐️1.2 Deep Belief Network(DBN)(Milestone of Deep Learning Eve)

[2] Hinton, Geoffrey E., Simon Osindero, and Yee-Whye Teh. "A fast learning algorithm for deep belief nets." Neural computation 18.7 (2006): 1527-1554. [pdf](Deep Learning Eve) ⭐️⭐️⭐️ [3] Hinton, Geoffrey E., and Ruslan R. Salakhutdinov. "Reducing the dimensionality of data with neural networks." Science 313.5786 (2006): 504-507. [pdf] (Milestone, Show the promise of deep learning) ⭐️⭐️⭐️1.3 ImageNet Evolution(Deep Learning broke out from here)

[4] Krizhevsky, Alex, Ilya Sutskever, and Geoffrey E. Hinton. "Imagenet classification with deep convolutional neural networks." Advances in neural information processing systems. 2012. [pdf] (AlexNet, Deep Learning Breakthrough) ⭐️⭐️⭐️⭐️⭐️ [5] Simonyan, Karen, and Andrew Zisserman. "Very deep convolutional networks for large-scale image recognition." arXiv preprint arXiv:1409.1556 (2014). [pdf] (VGGNet,Neural Networks become very deep!) ⭐️⭐️⭐️ [6] Szegedy, Christian, et al. "Going deeper with convolutions." Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015. [pdf] (GoogLeNet) ⭐️⭐️⭐️ [7] He, Kaiming, et al. "Deep residual learning for image recognition." arXiv preprint arXiv:1512.03385 (2015). [pdf](ResNet,Very very deep networks, CVPR best paper) ⭐️⭐️⭐️⭐️⭐️1.4 Speech Recognition Evolution

[8] Hinton, Geoffrey, et al. "Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups." IEEE Signal Processing Magazine 29.6 (2012): 82-97. [pdf] (Breakthrough in speech recognition)⭐️⭐️⭐️⭐️ [9] Graves, Alex, Abdel-rahman Mohamed, and Geoffrey Hinton. "Speech recognition with deep recurrent neural networks." 2013 IEEE international conference on acoustics, speech and signal processing. IEEE, 2013. [pdf](RNN)⭐️⭐️⭐️ [10] Graves, Alex, and Navdeep Jaitly. "Towards End-To-End Speech Recognition with Recurrent Neural Networks." ICML. Vol. 14. 2014. [pdf]⭐️⭐️⭐️ [11] Sak, Haşim, et al. "Fast and accurate recurrent neural network acoustic models for speech recognition." arXiv preprint arXiv:1507.06947 (2015). [pdf] (Google Speech Recognition System) ⭐️⭐️⭐️ [12] Amodei, Dario, et al. "Deep speech 2: End-to-end speech recognition in english and mandarin." arXiv preprint arXiv:1512.02595 (2015). [pdf] (Baidu Speech Recognition System) ⭐️⭐️⭐️⭐️ [13] W. Xiong, J. Droppo, X. Huang, F. Seide, M. Seltzer, A. Stolcke, D. Yu, G. Zweig "Achieving Human Parity in Conversational Speech Recognition." arXiv preprint arXiv:1610.05256 (2016). [pdf] (State-of-the-art in speech recognition, Microsoft) ⭐️⭐️⭐️⭐️After reading above papers, you will have a basic understanding of the Deep Learning history, the basic architectures of Deep Learning model(including CNN, RNN, LSTM) and how deep learning can be applied to image and speech recognition issues. The following papers will take you in-depth understanding of the Deep Learning method, Deep Learning in different areas of application and the frontiers. I suggest that you can choose the following papers based on your interests and research direction.

2 Deep Learning Method

2.1 Model

[14] Hinton, Geoffrey E., et al. "Improving neural networks by preventing co-adaptation of feature detectors." arXiv preprint arXiv:1207.0580 (2012). [pdf] (Dropout) ⭐️⭐️⭐️ [15] Srivastava, Nitish, et al. "Dropout: a simple way to prevent neural networks from overfitting." Journal of Machine Learning Research 15.1 (2014): 1929-1958. [pdf] ⭐️⭐️⭐️ [16] Ioffe, Sergey, and Christian Szegedy. "Batch normalization: Accelerating deep network training by reducing internal covariate shift." arXiv preprint arXiv:1502.03167 (2015). [pdf] (An outstanding Work in 2015) ⭐️⭐️⭐️⭐️ [17] Ba, Jimmy Lei, Jamie Ryan Kiros, and Geoffrey E. Hinton. "Layer normalization." arXiv preprint arXiv:1607.06450 (2016). [pdf] (Update of Batch Normalization) ⭐️⭐️⭐️⭐️ [18] Courbariaux, Matthieu, et al. "Binarized Neural Networks: Training Neural Networks with Weights and Activations Constrained to+ 1 or−1." [pdf] (New Model,Fast) ⭐️⭐️⭐️ [19] Jaderberg, Max, et al. "Decoupled neural interfaces using synthetic gradients." arXiv preprint arXiv:1608.05343 (2016). [pdf] (Innovation of Training Method,Amazing Work) ⭐️⭐️⭐️⭐️⭐️ [20] Chen, Tianqi, Ian Goodfellow, and Jonathon Shlens. "Net2net: Accelerating learning via knowledge transfer." arXiv preprint arXiv:1511.05641 (2015). [pdf] (Modify previously trained network to reduce training epochs)⭐️⭐️⭐️ [21] Wei, Tao, et al. "Network Morphism." arXiv preprint arXiv:1603.01670 (2016). [pdf] (Modify previously trained network to reduce training epochs) ⭐️⭐️⭐️2.2 Optimization

[22] Sutskever, Ilya, et al. "On the importance of initialization and momentum in deep learning." ICML (3) 28 (2013): 1139-1147. [pdf] (Momentum optimizer) ⭐️⭐️ [23] Kingma, Diederik, and Jimmy Ba. "Adam: A method for stochastic optimization." arXiv preprint arXiv:1412.6980 (2014). [pdf] (Maybe used most often currently) ⭐️⭐️⭐️ [24] Andrychowicz, Marcin, et al. "Learning to learn by gradient descent by gradient descent." arXiv preprint arXiv:1606.04474 (2016). [pdf] (Neural Optimizer,Amazing Work) ⭐️⭐️⭐️⭐️⭐️ [25] Han, Song, Huizi Mao, and William J. Dally. "Deep compression: Compressing deep neural network with pruning, trained quantization and huffman coding." CoRR, abs/1510.00149 2 (2015). [pdf] (ICLR best paper, new direction to make NN running fast,DeePhi Tech Startup) ⭐️⭐️⭐️⭐️⭐️ [26] Iandola, Forrest N., et al. "SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and< 1MB model size." arXiv preprint arXiv:1602.07360 (2016). [pdf] (Also a new direction to optimize NN,DeePhi Tech Startup)⭐️⭐️⭐️⭐️2.3 Unsupervised Learning / Deep Generative Model

[27] Le, Quoc V. "Building high-level features using large scale unsupervised learning." 2013 IEEE international conference on acoustics, speech and signal processing. IEEE, 2013. [pdf] (Milestone, Andrew Ng, Google Brain Project, Cat) ⭐️⭐️⭐️⭐️ [28] Kingma, Diederik P., and Max Welling. "Auto-encoding variational bayes." arXiv preprint arXiv:1312.6114 (2013). [pdf] (VAE) ⭐️⭐️⭐️⭐️ [29] Goodfellow, Ian, et al. "Generative adversarial nets." Advances in Neural Information Processing Systems. 2014. [pdf] (GAN,super cool idea) ⭐️⭐️⭐️⭐️⭐️ [30] Radford, Alec, Luke Metz, and Soumith Chintala. "Unsupervised representation learning with deep convolutional generative adversarial networks." arXiv preprint arXiv:1511.06434 (2015). [pdf] (DCGAN) ⭐️⭐️⭐️⭐️ [31] Gregor, Karol, et al. "DRAW: A recurrent neural network for image generation." arXiv preprint arXiv:1502.04623 (2015). [pdf] (VAE with attention, outstanding work) ⭐️⭐️⭐️⭐️⭐️ [32] Oord, Aaron van den, Nal Kalchbrenner, and Koray Kavukcuoglu. "Pixel recurrent neural networks." arXiv preprint arXiv:1601.06759 (2016). [pdf] (PixelRNN) ⭐️⭐️⭐️⭐️ [33] Oord, Aaron van den, et al. "Conditional image generation with PixelCNN decoders." arXiv preprint arXiv:1606.05328 (2016). [pdf] (PixelCNN) ⭐️⭐️⭐️⭐️2.4 RNN / Sequence-to-Sequence Model

[34] Graves, Alex. "Generating sequences with recurrent neural networks." arXiv preprint arXiv:1308.0850 (2013).[pdf] (LSTM, very nice generating result, show the power of RNN) ⭐️⭐️⭐️⭐️ [35] Cho, Kyunghyun, et al. "Learning phrase representations using RNN encoder-decoder for statistical machine translation." arXiv preprint arXiv:1406.1078 (2014). [pdf] (First Seq-to-Seq Paper) ⭐️⭐️⭐️⭐️ [36] Sutskever, Ilya, Oriol Vinyals, and Quoc V. Le. "Sequence to sequence learning with neural networks." Advances in neural information processing systems. 2014. [pdf] (Outstanding Work) ⭐️⭐️⭐️⭐️⭐️ [37] Bahdanau, Dzmitry, KyungHyun Cho, and Yoshua Bengio. "Neural Machine Translation by Jointly Learning to Align and Translate." arXiv preprint arXiv:1409.0473 (2014). [pdf] ⭐️⭐️⭐️⭐️ [38] Vinyals, Oriol, and Quoc Le. "A neural conversational model." arXiv preprint arXiv:1506.05869 (2015). [pdf](Seq-to-Seq on Chatbot) ⭐️⭐️⭐️2.5 Neural Turing Machine

[39] Graves, Alex, Greg Wayne, and Ivo Danihelka. "Neural turing machines." arXiv preprint arXiv:1410.5401 (2014).[pdf] (Basic Prototype of Future Computer) ⭐️⭐️⭐️⭐️⭐️ [40] Zaremba, Wojciech, and Ilya Sutskever. "Reinforcement learning neural Turing machines." arXiv preprint arXiv:1505.00521 362 (2015). [pdf] ⭐️⭐️⭐️ [41] Weston, Jason, Sumit Chopra, and Antoine Bordes. "Memory networks." arXiv preprint arXiv:1410.3916 (2014).[pdf] ⭐️⭐️⭐️ [42] Sukhbaatar, Sainbayar, Jason Weston, and Rob Fergus. "End-to-end memory networks." Advances in neural information processing systems. 2015. [pdf] ⭐️⭐️⭐️⭐️ [43] Vinyals, Oriol, Meire Fortunato, and Navdeep Jaitly. "Pointer networks." Advances in Neural Information Processing Systems. 2015. [pdf] ⭐️⭐️⭐️⭐️ [44] Graves, Alex, et al. "Hybrid computing using a neural network with dynamic external memory." Nature (2016).[pdf] (Milestone,combine above papers' ideas) ⭐️⭐️⭐️⭐️⭐️2.6 Deep Reinforcement Learning

[45] Mnih, Volodymyr, et al. "Playing atari with deep reinforcement learning." arXiv preprint arXiv:1312.5602 (2013). [pdf]) (First Paper named deep reinforcement learning) ⭐️⭐️⭐️⭐️ [46] Mnih, Volodymyr, et al. "Human-level control through deep reinforcement learning." Nature 518.7540 (2015): 529-533. [pdf] (Milestone) ⭐️⭐️⭐️⭐️⭐️ [47] Wang, Ziyu, Nando de Freitas, and Marc Lanctot. "Dueling network architectures for deep reinforcement learning." arXiv preprint arXiv:1511.06581 (2015). [pdf] (ICLR best paper,great idea) ⭐️⭐️⭐️⭐️ [48] Mnih, Volodymyr, et al. "Asynchronous methods for deep reinforcement learning." arXiv preprint arXiv:1602.01783 (2016). [pdf] (State-of-the-art method) ⭐️⭐️⭐️⭐️⭐️ [49] Lillicrap, Timothy P., et al. "Continuous control with deep reinforcement learning." arXiv preprint arXiv:1509.02971 (2015). [pdf] (DDPG) ⭐️⭐️⭐️⭐️ [50] Gu, Shixiang, et al. "Continuous Deep Q-Learning with Model-based Acceleration." arXiv preprint arXiv:1603.00748 (2016). [pdf] (NAF) ⭐️⭐️⭐️⭐️ [51] Schulman, John, et al. "Trust region policy optimization." CoRR, abs/1502.05477 (2015). [pdf] (TRPO)⭐️⭐️⭐️⭐️ [52] Silver, David, et al. "Mastering the game of Go with deep neural networks and tree search." Nature 529.7587 (2016): 484-489. [pdf] (AlphaGo) ⭐️⭐️⭐️⭐️⭐️2.7 Deep Transfer Learning / Lifelong Learning / especially for RL

[53] Bengio, Yoshua. "Deep Learning of Representations for Unsupervised and Transfer Learning." ICML Unsupervised and Transfer Learning 27 (2012): 17-36. [pdf] (A Tutorial) ⭐️⭐️⭐️ [54] Silver, Daniel L., Qiang Yang, and Lianghao Li. "Lifelong Machine Learning Systems: Beyond Learning Algorithms." AAAI Spring Symposium: Lifelong Machine Learning. 2013. [pdf] (A brief discussion about lifelong learning) ⭐️⭐️⭐️ [55] Hinton, Geoffrey, Oriol Vinyals, and Jeff Dean. "Distilling the knowledge in a neural network." arXiv preprint arXiv:1503.02531 (2015). [pdf] (Godfather's Work) ⭐️⭐️⭐️⭐️ [56] Rusu, Andrei A., et al. "Policy distillation." arXiv preprint arXiv:1511.06295 (2015). [pdf] (RL domain) ⭐️⭐️⭐️ [57] Parisotto, Emilio, Jimmy Lei Ba, and Ruslan Salakhutdinov. "Actor-mimic: Deep multitask and transfer reinforcement learning." arXiv preprint arXiv:1511.06342 (2015). [pdf] (RL domain) ⭐️⭐️⭐️ [58] Rusu, Andrei A., et al. "Progressive neural networks." arXiv preprint arXiv:1606.04671 (2016). [pdf](Outstanding Work, A novel idea) ⭐️⭐️⭐️⭐️⭐️2.8 One Shot Deep Learning

[59] Lake, Brenden M., Ruslan Salakhutdinov, and Joshua B. Tenenbaum. "Human-level concept learning through probabilistic program induction." Science 350.6266 (2015): 1332-1338. [pdf] (No Deep Learning,but worth reading) ⭐️⭐️⭐️⭐️⭐️ [60] Koch, Gregory, Richard Zemel, and Ruslan Salakhutdinov. "Siamese Neural Networks for One-shot Image Recognition."(2015) [pdf] ⭐️⭐️⭐️ [61] Santoro, Adam, et al. "One-shot Learning with Memory-Augmented Neural Networks." arXiv preprint arXiv:1605.06065 (2016). [pdf] (A basic step to one shot learning) ⭐️⭐️⭐️⭐️ [62] Vinyals, Oriol, et al. "Matching Networks for One Shot Learning." arXiv preprint arXiv:1606.04080 (2016). [pdf]⭐️⭐️⭐️ [63] Hariharan, Bharath, and Ross Girshick. "Low-shot visual object recognition." arXiv preprint arXiv:1606.02819 (2016). [pdf] (A step to large data) ⭐️⭐️⭐️⭐️3 Applications

3.1 NLP(Natural Language Processing)

[1] Antoine Bordes, et al. "Joint Learning of Words and Meaning Representations for Open-Text Semantic Parsing." AISTATS(2012) [pdf] ⭐️⭐️⭐️⭐️ [2] Mikolov, et al. "Distributed representations of words and phrases and their compositionality." ANIPS(2013): 3111-3119 [pdf] (word2vec) ⭐️⭐️⭐️ [3] Sutskever, et al. "“Sequence to sequence learning with neural networks." ANIPS(2014) [pdf] ⭐️⭐️⭐️ [4] Ankit Kumar, et al. "“Ask Me Anything: Dynamic Memory Networks for Natural Language Processing." arXiv preprint arXiv:1506.07285(2015) [pdf] ⭐️⭐️⭐️⭐️ [5] Yoon Kim, et al. "Character-Aware Neural Language Models." NIPS(2015) arXiv preprint arXiv:1508.06615(2015)[pdf] ⭐️⭐️⭐️⭐️ [6] Jason Weston, et al. "Towards AI-Complete Question Answering: A Set of Prerequisite Toy Tasks." arXiv preprint arXiv:1502.05698(2015) [pdf] (bAbI tasks) ⭐️⭐️⭐️ [7] Karl Moritz Hermann, et al. "Teaching Machines to Read and Comprehend." arXiv preprint arXiv:1506.03340(2015) [pdf] (CNN/DailyMail cloze style questions) ⭐️⭐️ [8] Alexis Conneau, et al. "Very Deep Convolutional Networks for Natural Language Processing." arXiv preprint arXiv:1606.01781(2016) [pdf] (state-of-the-art in text classification) ⭐️⭐️⭐️ [9] Armand Joulin, et al. "Bag of Tricks for Efficient Text Classification." arXiv preprint arXiv:1607.01759(2016)[pdf] (slightly worse than state-of-the-art, but a lot faster) ⭐️⭐️⭐️3.2 Object Detection

[1] Szegedy, Christian, Alexander Toshev, and Dumitru Erhan. "Deep neural networks for object detection." Advances in Neural Information Processing Systems. 2013. [pdf] ⭐️⭐️⭐️ [2] Girshick, Ross, et al. "Rich feature hierarchies for accurate object detection and semantic segmentation." Proceedings of the IEEE conference on computer vision and pattern recognition. 2014. [pdf] (RCNN) ⭐️⭐️⭐️⭐️⭐️ [3] He, Kaiming, et al. "Spatial pyramid pooling in deep convolutional networks for visual recognition." European Conference on Computer Vision. Springer International Publishing, 2014. [pdf] (SPPNet) ⭐️⭐️⭐️⭐️ [4] Girshick, Ross. "Fast r-cnn." Proceedings of the IEEE International Conference on Computer Vision. 2015. [pdf]⭐️⭐️⭐️⭐️ [5] Ren, Shaoqing, et al. "Faster R-CNN: Towards real-time object detection with region proposal networks." Advances in neural information processing systems. 2015. [pdf] ⭐️⭐️⭐️⭐️ [6] Redmon, Joseph, et al. "You only look once: Unified, real-time object detection." arXiv preprint arXiv:1506.02640 (2015). [pdf] (YOLO,Oustanding Work, really practical) ⭐️⭐️⭐️⭐️⭐️ [7] Liu, Wei, et al. "SSD: Single Shot MultiBox Detector." arXiv preprint arXiv:1512.02325 (2015). [pdf] ⭐️⭐️⭐️3.3 Visual Tracking

[1] Wang, Naiyan, and Dit-Yan Yeung. "Learning a deep compact image representation for visual tracking." Advances in neural information processing systems. 2013. [pdf] (First Paper to do visual tracking using Deep Learning,DLT Tracker) ⭐️⭐️⭐️ [2] Wang, Naiyan, et al. "Transferring rich feature hierarchies for robust visual tracking." arXiv preprint arXiv:1501.04587 (2015). [pdf] (SO-DLT) ⭐️⭐️⭐️⭐️ [3] Wang, Lijun, et al. "Visual tracking with fully convolutional networks." Proceedings of the IEEE International Conference on Computer Vision. 2015. [pdf] (FCNT) ⭐️⭐️⭐️⭐️ [4] Held, David, Sebastian Thrun, and Silvio Savarese. "Learning to Track at 100 FPS with Deep Regression Networks." arXiv preprint arXiv:1604.01802 (2016). [pdf] (GOTURN,Really fast as a deep learning method,but still far behind un-deep-learning methods) ⭐️⭐️⭐️⭐️ [5] Bertinetto, Luca, et al. "Fully-Convolutional Siamese Networks for Object Tracking." arXiv preprint arXiv:1606.09549 (2016). [pdf] (SiameseFC,New state-of-the-art for real-time object tracking) ⭐️⭐️⭐️⭐️ [6] Martin Danelljan, Andreas Robinson, Fahad Khan, Michael Felsberg. "Beyond Correlation Filters: Learning Continuous Convolution Operators for Visual Tracking." ECCV (2016) [pdf] (C-COT) ⭐️⭐️⭐️⭐️ [7] Nam, Hyeonseob, Mooyeol Baek, and Bohyung Han. "Modeling and Propagating CNNs in a Tree Structure for Visual Tracking." arXiv preprint arXiv:1608.07242 (2016). [pdf] (VOT2016 Winner,TCNN) ⭐️⭐️⭐️⭐️3.4 Image Caption

[1] Farhadi,Ali,etal. "Every picture tells a story: Generating sentences from images". In Computer VisionECCV 2010. Springer Berlin Heidelberg:15-29, 2010. [pdf] ⭐️⭐️⭐️ [2] Kulkarni, Girish, et al. "Baby talk: Understanding and generating image descriptions". In Proceedings of the 24th CVPR, 2011. [pdf]⭐️⭐️⭐️⭐️ [3] Vinyals, Oriol, et al. "Show and tell: A neural image caption generator". In arXiv preprint arXiv:1411.4555, 2014.[pdf]⭐️⭐️⭐️ [4] Donahue, Jeff, et al. "Long-term recurrent convolutional networks for visual recognition and description". In arXiv preprint arXiv:1411.4389 ,2014. [pdf] [5] Karpathy, Andrej, and Li Fei-Fei. "Deep visual-semantic alignments for generating image descriptions". In arXiv preprint arXiv:1412.2306, 2014. [pdf]⭐️⭐️⭐️⭐️⭐️ [6] Karpathy, Andrej, Armand Joulin, and Fei Fei F. Li. "Deep fragment embeddings for bidirectional image sentence mapping". In Advances in neural information processing systems, 2014. [pdf]⭐️⭐️⭐️⭐️ [7] Fang, Hao, et al. "From captions to visual concepts and back". In arXiv preprint arXiv:1411.4952, 2014.[pdf]⭐️⭐️⭐️⭐️⭐️ [8] Chen, Xinlei, and C. Lawrence Zitnick. "Learning a recurrent visual representation for image caption generation". In arXiv preprint arXiv:1411.5654, 2014. [pdf]⭐️⭐️⭐️⭐️ [9] Mao, Junhua, et al. "Deep captioning with multimodal recurrent neural networks (m-rnn)". In arXiv preprint arXiv:1412.6632, 2014. [pdf]⭐️⭐️⭐️ [10] Xu, Kelvin, et al. "Show, attend and tell: Neural image caption generation with visual attention". In arXiv preprint arXiv:1502.03044, 2015. [pdf]⭐️⭐️⭐️⭐️⭐️3.5 Machine Translation

Some milestone papers are listed in RNN / Seq-to-Seq topic.[1] Luong, Minh-Thang, et al. "Addressing the rare word problem in neural machine translation." arXiv preprint arXiv:1410.8206 (2014). [pdf] ⭐️⭐️⭐️⭐️ [2] Sennrich, et al. "Neural Machine Translation of Rare Words with Subword Units". In arXiv preprint arXiv:1508.07909, 2015. [pdf]⭐️⭐️⭐️ [3] Luong, Minh-Thang, Hieu Pham, and Christopher D. Manning. "Effective approaches to attention-based neural machine translation." arXiv preprint arXiv:1508.04025 (2015). [pdf] ⭐️⭐️⭐️⭐️ [4] Chung, et al. "A Character-Level Decoder without Explicit Segmentation for Neural Machine Translation". In arXiv preprint arXiv:1603.06147, 2016. [pdf]⭐️⭐️ [5] Lee, et al. "Fully Character-Level Neural Machine Translation without Explicit Segmentation". In arXiv preprint arXiv:1610.03017, 2016. [pdf]⭐️⭐️⭐️⭐️⭐️ [6] Wu, Schuster, Chen, Le, et al. "Google's Neural Machine Translation System: Bridging the Gap between Human and Machine Translation". In arXiv preprint arXiv:1609.08144v2, 2016. [pdf] (Milestone) ⭐️⭐️⭐️⭐️

3.6 Robotics

[1] Koutník, Jan, et al. "Evolving large-scale neural networks for vision-based reinforcement learning." Proceedings of the 15th annual conference on Genetic and evolutionary computation. ACM, 2013. [pdf] ⭐️⭐️⭐️ [2] Levine, Sergey, et al. "End-to-end training of deep visuomotor policies." Journal of Machine Learning Research 17.39 (2016): 1-40. [pdf] ⭐️⭐️⭐️⭐️⭐️ [3] Pinto, Lerrel, and Abhinav Gupta. "Supersizing self-supervision: Learning to grasp from 50k tries and 700 robot hours." arXiv preprint arXiv:1509.06825 (2015). [pdf] ⭐️⭐️⭐️ [4] Levine, Sergey, et al. "Learning Hand-Eye Coordination for Robotic Grasping with Deep Learning and Large-Scale Data Collection." arXiv preprint arXiv:1603.02199 (2016). [pdf] ⭐️⭐️⭐️⭐️ [5] Zhu, Yuke, et al. "Target-driven Visual Navigation in Indoor Scenes using Deep Reinforcement Learning." arXiv preprint arXiv:1609.05143 (2016). [pdf] ⭐️⭐️⭐️⭐️ [6] Yahya, Ali, et al. "Collective Robot Reinforcement Learning with Distributed Asynchronous Guided Policy Search." arXiv preprint arXiv:1610.00673 (2016). [pdf] ⭐️⭐️⭐️⭐️ [7] Gu, Shixiang, et al. "Deep Reinforcement Learning for Robotic Manipulation." arXiv preprint arXiv:1610.00633 (2016). [pdf] ⭐️⭐️⭐️⭐️ [8] A Rusu, M Vecerik, Thomas Rothörl, N Heess, R Pascanu, R Hadsell."Sim-to-Real Robot Learning from Pixels with Progressive Nets." arXiv preprint arXiv:1610.04286 (2016). [pdf] ⭐️⭐️⭐️⭐️3.7 Art

[1] Mordvintsev, Alexander; Olah, Christopher; Tyka, Mike (2015). "Inceptionism: Going Deeper into Neural Networks". Google Research. [html] (Deep Dream) ⭐️⭐️⭐️⭐️ [2] Gatys, Leon A., Alexander S. Ecker, and Matthias Bethge. "A neural algorithm of artistic style." arXiv preprint arXiv:1508.06576 (2015). [pdf] (Outstanding Work, most successful method currently) ⭐️⭐️⭐️⭐️⭐️ [3] Zhu, Jun-Yan, et al. "Generative Visual Manipulation on the Natural Image Manifold." European Conference on Computer Vision. Springer International Publishing, 2016. [pdf] (iGAN) ⭐️⭐️⭐️⭐️ [4] Champandard, Alex J. "Semantic Style Transfer and Turning Two-Bit Doodles into Fine Artworks." arXiv preprint arXiv:1603.01768 (2016). [pdf] (Neural Doodle) ⭐️⭐️⭐️⭐️ [5] Zhang, Richard, Phillip Isola, and Alexei A. Efros. "Colorful Image Colorization." arXiv preprint arXiv:1603.08511 (2016). [pdf] ⭐️⭐️⭐️⭐️ [6] Johnson, Justin, Alexandre Alahi, and Li Fei-Fei. "Perceptual losses for real-time style transfer and super-resolution." arXiv preprint arXiv:1603.08155 (2016). [pdf] ⭐️⭐️⭐️⭐️3.8 Audio

3.9 Game

3.10 Knowledge Graph

3.11 Recommender Systems

3.12 Bioinformatics / Computational Biology

3.13 Neural Network Chip

3.14 Other Frontiers

分布式服务框架dubbo原理解析

- ConfigServer

| serviceName | serverAddressList | clientAddressList |

| UserService | 192.168.0.1,192.168.0.2,192.168.0.3,192.168.0.4 | 172.16.0.1,172.16.0.2 |

| ProductService | 192.168.0.3,192.168.0.4,192.168.0.5,192.168.0.6 | 172.16.0.2,172.16.0.3 |

| OrderService | 192.168.0.10,192.168.0.12,192.168.0.5,192.168.0.6 | 172.16.0.3,172.16.0.4 |

- Client

- Server

[Yol出品]也说单例模式

[mysql]启动报错:MySQL Daemon failed to start. File ‘./ibtmp1’ size is now 12 MB.

[Java][集合总结]Collection List Set Map 是否有序及原因一语道破天机

| 有序否 | 允许元素重复否 | ||

| Collection | 否 | 是 | |

| List | 是 | 是 | |

| Set | AbstractSet | 否 | 否(原因是hashcode) |

| HashSet | |||

| TreeSet | 是(用二叉树排序) | ||

| Map | AbstractMap | 否 | 使用key-value来映射和存储数据,Key必须惟一,value可以重复 |

| HashMap | |||

| TreeMap | 是(用二叉树排序) | ||

[算法][算法性能]各大排序算法性能比较

[排序算法]图解插入排序–直接插入排序

本文:http://www.paymoon.com:8001/index.php/2016/11/03/insertsort/

排序思路:每次将一个待排序的元素与已排序的元素进行逐一比较,直到找到合适的位置按大小插入。

第一趟比较示图:

算法实现:

结果:

算法分析:1.当元素的初始序列为正序时,仅外循环要进行n-1趟排序且每一趟只进行一次比较,没有进入if语句不存在元素之间的交换(移动)。此时比较次数(Cmin)和移动次数(Mmin)达到 最小值。

Cmin = n-1 Mmin = 0;

此时时间复杂度为O(n)。

2.当元素的初始序列为反序时,每趟排序中待插入的元素都要和[0,i-1]中的i个元素进行比较且要将这i个元素后移(arr[j+1] = arr[j]),i个元素后移移动次数当然也就为i 了,再加上temp = arr[i]与arr[j+1] = temp的两次移动,每趟移动的次数为i+2,此时比较次数(Cmin)和移动次数(Mmin)达到最小值。

Cmax = 1+2+...+(n-1) = n*(n-1)/2 = O(n2)

Mmax = (1+2)+(2+2)+...+(n-1+2) = (n-1)*(n+4)/2 = O(n2) (i取值范围1~n-1)

此时时间复杂度为O(n2)。

3.在直接插入排序中只使用了i,j,temp这3个辅助元素,与问题规模无关,所以空间复杂度为O(1).

4.在整个排序结束后,即使有相同元素它们的相对位置也没有发生变化,

如:5,3,2,3排序过程如下

A--3,5,2,3

B--2,3,5,3

C--2,3,3,5

排序结束后两个元素3的相对位置没有发生改变,所以直接插入排序是一种稳定排序

原文:http://www.cnblogs.com/MOBIN/p/4679208.html

本文:http://www.paymoon.com:8001/index.php/2016/11/03/insertsort/

[摘抄]序言 谷歌的“痴心妄想”&基本物理原则[first principle and real-world physics]

什么才是演讲的“基本物理原则”?what is speaking first principle and real-world physics

Google联合创始人Larry Page为Eric Schmidt的著作“How Google Works”写了序言。开头写了一句很重要的话:

…… 从基本物理原则出发思考问题,不必迎合那些“世俗智慧”。

(…… think form first principle and real-world physics rather than having to accept the prevailing “wisdom”. )

我的学员很多都是创意精英。他们是工程师、产品经理和技术专家,或者是这样出身的高级经理人。

在演讲这件事上,创意精英们不会考虑“世俗智慧”。他们不会在自己的职业能力之上,鲁莽地嫁接一个打鸡血型的演讲技能,或者附上一个成功学口才大师的精神附体。因为这些东西本身就是笑柄,与创意精英内在的品性完全相悖。

创意精英对这些“世俗智慧”的排斥反应是先天的。所以,他们不会崇拜口才大师的江湖经验,也不会迷信成功学的街头智慧。甚至一个带着师爷气的培训师,都不会被他们邀请去上课。

可是话说回来,什么才是演讲的“基本物理原则”?

这个问题在扣问这个行当的本质,也在考验从业老师的理解力。这个问题我已经思考了很长一段时间,也未能得到满意的答案。以下,只是我这个阶段的想法:

- 演讲不只是个物,它还是一个过程。要理解这个过程的动态性和演进性。

- 要为过程设计一个策略。策略必须朴素而真实,它从根本上来自于你看待和对待听众的方式。

- 演讲是对讲者和观众这二者之间某种关系的处理。所以,演讲具有很多二元性的特征,演讲方法有很多双重的策略。

- 严格考察你的动机和对听众的价值。你从前者出发,最终到达后者。

- 演讲是由演讲者和听众共同完成的。

- 知彼解己(First to understand, then to understood)。达到这个状态,才可以享受演讲的美好。

- 理解情境(Context)。演讲的情境之中,最重要的要素是:谁来听?他们因何来听?听完之后他们能怎样?你想讲什么?注意:“你想讲什么”这个放在最后,是故意的,也是必须的。

- 除了逻辑严密、思路清晰、表达准确之外,还要考虑和观众的情感互动。

- 演讲是视听多维度的一种体验。视听多个信息通道的设计和安排,具有艺术性。

- 相比其他的独立技能,演讲能力更为综合。

这有点晦涩?是的。“基本物理原则”不一定好理解,每个还需要解析。这个清单还会增加或者改写,我更希望它能变短。这仅仅是我理解的“基本物理原则”,它除了指导我的工作,也可以给你中肯的提醒:

请找到你的“基本物理原则”。-- gary_yang

重读《资本论》:马克思到底在说什么?

重读《资本论》:马克思到底在说什么?

来源:财经微信号 作者:弗雷德里克·杰姆逊

弗雷德里克·杰姆逊

【简介】弗雷德里克·杰姆逊,1934年4月出生于美国的克里夫兰,在耶鲁大学获得硕博士学位,博士专业方向是法国文学,博士论文是《萨特:一种风格的起源》。耶鲁毕业后,在哈佛大学任教。他的文学理论专著《马克思主义与形式》 (1971)、《语言的牢笼》(1972)、《政治无意识》(1981)获得了极高的声誉,被称为“马克思主义的三部曲”。

1985年,杰姆逊访问北京大学,引发了学界关于西方马克思主义以及后现代文化研究的热潮。2002年,他再次登上华东师范大学的演讲台,引起学界广泛关注。

不久前,78岁高龄的杰姆逊开启了他的又一次中国巡讲,先后在北京大学、华东师范大学以及《文汇报》进行了演讲和座谈,本文是其在华东师范大学的演讲——“资本论新解”。

这次演讲的特殊之处需作一些说明。演讲分为两个部分,第一部分谈的是《资本论》第一卷,第二部分谈的是全球化条件下的经验与政治,两部分的相通之处在于:都是重新思考马克思主义的当代相关性。

《资本论》:一本关于失业的书

我对马克思如何来呈现事实不感兴趣,对那些据说是他从事实中推演出来的相关规律也不感兴趣。此次全球范围内的经济危机足以证明马克思对于资本描述的正确性。

《资本论》第一卷已为我们描绘了一幅资本主义的完整图画。对我来说,《资本论》第一卷主要的、形式意义上的问题关乎再现/表 征的问题,即如何从个别元素、历史过程和各种角度来构造一种总体性;尤其是如何公正地对待这种总体性;作为一种关系系统,它不仅是非经验性的,而且是完全处于运动之中的,不断扩张,处于总体化运动之中。这对于资本主义的存在来说是本质性的,也是其独特经济本性最为核心的部分。然而,永恒的崩溃过程对于资本主义结构来说也是本质性的:于是,在这儿我们就有了这样一种机器,它不可避免地会崩溃,因此为了维持自己的实存,它必须不断地用扩张自身、扩张自己控制领域的方式来修复自身。

曾有人认为货币可以解决《资本论》第一卷(论商品)的等价问题,这当然是一种错误的解答,因为货币并不是一种解决方式而是一种中介:货币是二元性的,它被用于表达一种关系,可实际上却隐藏了这种关系本身。这种货币的神秘本性解释了为何如此多的乌托邦围绕以下原则组织架构自身:摆脱货币就将摆脱所有问题。如果货币是一种真正的解决,那么诸如商品及劳动的“合理价格”这样的东西就是可能的,因而社会民主自身是可能的:可以用这样的方式来修补资本主义,从而将它改造成一个公正的社会。另一方面,蒲鲁东的伟大口号:“财产即偷窃”——也让人无法满意,因为它假定以无政府主义精神摆脱货币将废除更深层的问题,可是货币仅仅只是这一问题的症候而已。货币、财产、资本主义自身依赖一种深层的结构性矛盾,或者至少它们依赖一种结构性的悖论(劳动价值论告诉了我们这一悖论的答案),因此无法用法令或修补的方式来解决这一问题。

为了解决这一问题,我们必然会转入生产过程——资本与新的资本只能在这里得到生产。有了生产自身,它很快就将我们引向了劳动价值论的秘密之处,引向了解答。这里的问题表现为:突然间引入了时间——虽说依旧是量化的、静态的、非辩证的方式。劳动价值论导向了所有关于利润率、劳动小时数以及那些有趣的变量组合的计算(这满足了马克思自己的兴趣,他对于数学与微积分的兴趣可以排在第二位)。然而突然之间,这些探究撞了墙:工作日的限制、法律对于工作日的限定、工厂法所要求的限制,突然间阻碍了资本必然的扩张。

因此,论述必须进入一个 新的论域,一个新的层面,问题和解答在这里都充满着强度:赞美集体性或协作。马克思兴高采烈地称之为“赐予资本的免费礼物”:协作劳动以辩证的方式成倍地增加了价值和产品。这当然是亚当·斯密的发现,而在这里它成了马克思的形而上学。马克思主义并非赋予生产以价值,而是赋予集体生产以价值。论协作的一章是《资本论》第一卷跳动的心脏。

然而,这一赞美是短命 的。当协作转化为机器时,这一赞美人类的原则成了名副其实的弗兰肯斯坦所创造的怪物。然而,这一全新现象从根本上转化了整个问题。它导向一种更复杂的新的时间理论以及关于资本主义“毁灭”了过去的理论,同时又导向以下问题的新解答:新的立法阻碍了绝对剩余价值,使之停滞。——提高生产力,强化价值生产却不延长价值生产,这一理论名为“相对剩余价值”论。

辩证地看,这一本来可以让马克思总结自己著作的新解答——机器、工业技术,却导致了一个全新的概念两难。这一两难有两种形式:首先,节省劳动的装置突然导致了劳动者(特别是童工)工作时间令人震惊的上升。其次,节省劳动的机器本该压缩劳动者的数量,不过是以让工人失业的形式进行的。在这一事例中,我们的两难局面具有了另一种形式:如果价值源于劳动,假定劳动者越多,那么所生产的价值也就越多,可资本家为什么坚持压缩劳动者的数量?

在这一点上,整个过程的 真理也变得越来越清晰了,马克思将决定性地阐明他所谓“资本主义积累的一般规律”,即他在同一文本脉络中称之为“绝对”规律的东西。以下是我的引用:“社会的财富即执行职能的资本越大,它的增长的规模和能力越大,从而无产阶级的绝对数量和他们的劳动生产力越大,产业后备军也就越大。可供支配的劳动力同资本的膨胀力一样,是由同一些原因发展起来的。因此,产业后备军的相对量和财富的力量一同增长。”当我们记起这一正式的响亮的表达——“产业后备军”——仅仅指失业者的时候,我们就拥有了更具戏剧意味、更容易获得的辩证悖论。它仅仅意味着资本主义的绝对规律是:增加财富和生产力的同时,不断增加失业者的数量。

现在我们可以回过头来评 价整部《资本论》的意义了。这是一本关于失业的书:抵达《资本论》概念顶端的是以下命题,即产业资本主义一方面生产出数量巨大的资本——这种资本在潜在的意义上是无法投资的,另一方面制造出人数不断上升的失业人群。当前第三阶段资本主义或金融资本的危机可以充分证实这一情况。

并没有描绘社会主义的样子

我想补充的是,资本无关乎劳动:它关乎过度劳动,非人的过长的劳动时间以及前者被限定之后童工的大量产生都是例证。资本也与这一著名的“产业后备军”相关,也就是说,与失业者相关。这里并不涉及Harry Braverman论泰勒制、劳动与垄断资本的经典著作所指向的严格意义上的劳动。然而,以下想法是错误的:历史发展已使这一资本主义总体性的19世纪再现变得陈腐过时:正相反,从马克思的著作中凸显出来的资本的时刻,恰恰在未来的运动中得到了仔细的勾勒——这些空间一方面是信用和金融资本,另一方面是帝国主义(马克思自己关于帝国主义的描述只是简单地谈及诸如澳大利亚这样的移民殖民地,虽然你可以从这一论原始积累的尾声中推导出我们所谓的今日帝国主义)。

因此,我必须下这样一个 结论,《资本论》并不是一本政治著作,除了建议工人组织起来之外,它关于资本的说明并没有任何政治后果。除了在第一部分举了一个假想的例子——联合起来的工人社会——之外,它并没有描绘社会主义的样子。然而,让我更为充分地来解释一下:马克思是一个真正的政治人物,大概除了列宁之外,马克思所具有的杰出的政治本能与政治思考无人能及。他是一个非同寻常的机会主义者,这是马基雅维利意义上的良好的机会主义。为了改变和废除资本主义,他可以向任何可能的道路开放:联合、暴动、议会选举中获胜、回到农村公社,甚至是资本在危机中自我毁灭,等等。如今每一种政治性的马克思主义运动——从社会民主派到列宁主义、毛泽东主义和无政府主义——都是马克思整个方案的可行的候选者,而他的议程则是随历史情境和资本主义自身的发展而改变的。然而,在《资本论》里却没有任何政治方案或是政治策略,《资本论》依然是阿尔都塞意义上的科学而非意识形态。

人们常常哀叹马克思主义 似乎只是纯粹的经济理论,没有为合适的马克思主义政治理论留出足够的空间。而我却认为这正是马克思主义的力量,政治理论和政治哲学总是附带性的。政治只应该是永远警惕的机会主义的事务,却不是任何理论或哲学的事务。在我看来,甚至当前以种种方式重新定义大众民主的努力也偏离了资本主义的本性与结构这一核心议题。永远也没有令人满意的政治解答或政治体系,但是可以有更好的经济体系。马克思主义者和左派需要把精力放在后一方面。

后现代:空间正在消除时间

接下来,我想首先转向后现代性中的日常生活领域,也就是转向主体性构造领域以及某一尚属推测中的新的后现代主体领域。毋庸置疑,信息技术的出现——此种发展完全改造了工业生产甚至是劳动自身——必然会带来主体性的改变,主体醒着的时间完全消耗在各种类型的电脑显示器前了。

就主体性和个人经验而 言,我们对时间的经验正被替换为对空间的经验。可事实是,我们在自己的主观意识里、在现象学的经验和生存体验里都感受着时间的存在。因此,我们需要追问,为什么这种时间感却要屈从于空间的统摄?我想,不仅是柏格森,还有托马斯·曼和普鲁斯特,这些现代主义者都迷恋深度时间。这种迷恋实际上根源于现代化进程的不平衡,于是造成了迟缓的乡村时间和令人眼花缭乱的都市及工业化节奏共存的情况。因此我们说,后现代是现代化的完成,是乡村的消失的结果(农民成为计时工人,原始农业变成农业产业)。在更充分的现代化中,工业劳动力和城市资产阶级的区分都被抹去。每个人都是消费者,每个人都成为雇佣者,一切东西都进了购物中心,空间不过是表面的无限延展。现代化不平衡发展在过去是由区域和民族国家体制造成的,现在则是由全球化造成的,文化自身成为不平衡发展的一个空间。这样,和全球化的联系就十分清楚了:如此辽阔的全球规模绝不可能在以帝国主义、大都市和殖民为代表的现代阶段出现,只有当殖民体系解体了,它才有了出现的条件。

但是就今天的现实而言, 我们应该谈论的倒不是民族解放而是商业,不是一般的跨国公司,而是新的巨型国际商业集团出现所依赖的信息技术。在电脑化时代,空间的距离是如何正被翻译为实际存在时间的共时性的,也就是说,空间正在消除时间。投资、期货、廉价兜售国家货币、剥夺和并购,把未来打包作为可以买卖的商品,这些都被最新出现的交流工具加速实现着,柏格森主义所谓具有绵延特征的时间轨迹已荡然无存。时间的停滞严重地改变了或切割了人类的经验。

我将这称之为时间性的终 结,一切终止于身体和此刻。值得寻找的只是一个强化的现在,它的前后时刻都不再存在。我们的历史观也受到影响。从前的社会没有一个像我们现在的社会这样,有着如此少的功能性记忆和可怜的历史感。这一切和今天个人主体的转换干系重大。在后现代性第一次萌动中,结构主义和后结构主义者宣告了“主体的死亡”。他们看到资产阶级的个人主义因无法和庞大的体制力量抗衡而日趋衰落,同时也看到这种个人主义体现的是具有占有欲和侵略性的自我,而把这种自我唤起的资本主义竞争如今也已衰落。身体是资产阶级文化在消耗殆尽之前的最后现实,是转变、变化和变异的最后发生地,是主体的昂扬自信的激情消退后残留的一点点心情。

政治在本质上反映为掠夺土地

回头反思使我们看到,作为第三个资本主义阶段的全球化只是发生在20世纪60年代的激烈的反殖民运动另一个面向。资本主义在前两个阶段首先建立了民族工业和市场,随后进入帝国主义和抢占殖民地时期,并迅速发展了世界经济的殖民体系。这两个时期的一个共同标志是对他者的建构。首先是各式各样的民族国家把人民分成相互竞争的群体,人们的民族认同只能建立在对外国人和民族敌人的憎恨上,而各自的身份认同则通过相互指认为他者来完成。但是不久,特别是在欧洲,民族主义迅速放弃狭隘的民族立场,允许少数族裔和操不同语言的人发展自己的民族方案。

这种渐进的扩展不可与后 来的全球化相混淆。帝国主义体系是把殖民地的臣民当作他者来殖民的。种族的他者意识和充满欧洲中心主义或美国中心主义式的对落后的、贫弱的臣属文化的轻蔑将殖民地的人民视为前现代的人,将统治性文化和被统治文化区分开来。他者的世界体系就在作为第二个资本主义时期即帝国主义和现代性阶段建立起来了。

显然在反殖民运动中,这 一切都逐渐烟消云散了。臣属的他者们一向无权为自己辩护更不用说来管理自己了,现在则第一次如萨特所说,用自己的声音宣告自己存在的自由。一刹那,资产阶级主体和这些从前的他者们泯然一体了,整个世界被一种新的无名所统治。现在世界上存在的不仅仅是成千上万某个国家的公民,某个民族的语言,而是几十亿人。

那么这一切与政治是什么 关系呢?既然我们一直在讨论空间,我不妨就简单提出一个看法:今日之世界政治皆与房地产相关。后现代政治在本质上反映的是土地掠夺,在地区和全球范围都是如此。无论我们想到的是巴勒斯坦聚居地和难民营问题,还是原材料及其开发政策,或者生态问题,联邦制问题、公民权和移民问题,在大都市同时也在法国简易居住大棚、巴西贫民窟和小镇上发生的中产阶级化问题,今天的一切都和土地相关。按马克思主义术语说,这一切变化归于土地的商品化和残余的封建制以及农民阶层的消失,取而代之的是工业农业、农业商业以及农场工人。

那么时间去哪了?它在我们瞬间拥挤的手机电话和短信发射中,在西雅图、胜利广场和威斯康辛的群众游行人群里。这样的时间,正如我的朋友迈克·哈特和托尼·奈格里所说的,标志着乌合之众的出现。这已不是延绵时间里的政治,而就是此刻和现在的政治。奈格里让我们看到这种时间乃是一种构成性力量而不是被构成的力量。总而言之,这种新的此刻已成为后现代性的标识,一切都停留在此刻和身体里。在这新的无处不在的空间和短暂此刻的辩证法里,历史、历史性和对历史的感觉都成为失败者。过去已经不在,未来却无法憧憬。很显然,历史的消亡为我们的政治和政治实践罩上了阴沉的暗影。

PS: 留下邮箱的读者,可以收到[资本论].卡尔·马克思.全彩版书籍

弗雷德里克·杰姆逊

【简介】弗雷德里克·杰姆逊,1934年4月出生于美国的克里夫兰,在耶鲁大学获得硕博士学位,博士专业方向是法国文学,博士论文是《萨特:一种风格的起源》。耶鲁毕业后,在哈佛大学任教。他的文学理论专著《马克思主义与形式》 (1971)、《语言的牢笼》(1972)、《政治无意识》(1981)获得了极高的声誉,被称为“马克思主义的三部曲”。

1985年,杰姆逊访问北京大学,引发了学界关于西方马克思主义以及后现代文化研究的热潮。2002年,他再次登上华东师范大学的演讲台,引起学界广泛关注。

不久前,78岁高龄的杰姆逊开启了他的又一次中国巡讲,先后在北京大学、华东师范大学以及《文汇报》进行了演讲和座谈,本文是其在华东师范大学的演讲——“资本论新解”。

这次演讲的特殊之处需作一些说明。演讲分为两个部分,第一部分谈的是《资本论》第一卷,第二部分谈的是全球化条件下的经验与政治,两部分的相通之处在于:都是重新思考马克思主义的当代相关性。

《资本论》:一本关于失业的书

我对马克思如何来呈现事实不感兴趣,对那些据说是他从事实中推演出来的相关规律也不感兴趣。此次全球范围内的经济危机足以证明马克思对于资本描述的正确性。

《资本论》第一卷已为我们描绘了一幅资本主义的完整图画。对我来说,《资本论》第一卷主要的、形式意义上的问题关乎再现/表 征的问题,即如何从个别元素、历史过程和各种角度来构造一种总体性;尤其是如何公正地对待这种总体性;作为一种关系系统,它不仅是非经验性的,而且是完全处于运动之中的,不断扩张,处于总体化运动之中。这对于资本主义的存在来说是本质性的,也是其独特经济本性最为核心的部分。然而,永恒的崩溃过程对于资本主义结构来说也是本质性的:于是,在这儿我们就有了这样一种机器,它不可避免地会崩溃,因此为了维持自己的实存,它必须不断地用扩张自身、扩张自己控制领域的方式来修复自身。

曾有人认为货币可以解决《资本论》第一卷(论商品)的等价问题,这当然是一种错误的解答,因为货币并不是一种解决方式而是一种中介:货币是二元性的,它被用于表达一种关系,可实际上却隐藏了这种关系本身。这种货币的神秘本性解释了为何如此多的乌托邦围绕以下原则组织架构自身:摆脱货币就将摆脱所有问题。如果货币是一种真正的解决,那么诸如商品及劳动的“合理价格”这样的东西就是可能的,因而社会民主自身是可能的:可以用这样的方式来修补资本主义,从而将它改造成一个公正的社会。另一方面,蒲鲁东的伟大口号:“财产即偷窃”——也让人无法满意,因为它假定以无政府主义精神摆脱货币将废除更深层的问题,可是货币仅仅只是这一问题的症候而已。货币、财产、资本主义自身依赖一种深层的结构性矛盾,或者至少它们依赖一种结构性的悖论(劳动价值论告诉了我们这一悖论的答案),因此无法用法令或修补的方式来解决这一问题。

为了解决这一问题,我们必然会转入生产过程——资本与新的资本只能在这里得到生产。有了生产自身,它很快就将我们引向了劳动价值论的秘密之处,引向了解答。这里的问题表现为:突然间引入了时间——虽说依旧是量化的、静态的、非辩证的方式。劳动价值论导向了所有关于利润率、劳动小时数以及那些有趣的变量组合的计算(这满足了马克思自己的兴趣,他对于数学与微积分的兴趣可以排在第二位)。然而突然之间,这些探究撞了墙:工作日的限制、法律对于工作日的限定、工厂法所要求的限制,突然间阻碍了资本必然的扩张。

因此,论述必须进入一个 新的论域,一个新的层面,问题和解答在这里都充满着强度:赞美集体性或协作。马克思兴高采烈地称之为“赐予资本的免费礼物”:协作劳动以辩证的方式成倍地增加了价值和产品。这当然是亚当·斯密的发现,而在这里它成了马克思的形而上学。马克思主义并非赋予生产以价值,而是赋予集体生产以价值。论协作的一章是《资本论》第一卷跳动的心脏。

然而,这一赞美是短命 的。当协作转化为机器时,这一赞美人类的原则成了名副其实的弗兰肯斯坦所创造的怪物。然而,这一全新现象从根本上转化了整个问题。它导向一种更复杂的新的时间理论以及关于资本主义“毁灭”了过去的理论,同时又导向以下问题的新解答:新的立法阻碍了绝对剩余价值,使之停滞。——提高生产力,强化价值生产却不延长价值生产,这一理论名为“相对剩余价值”论。

辩证地看,这一本来可以让马克思总结自己著作的新解答——机器、工业技术,却导致了一个全新的概念两难。这一两难有两种形式:首先,节省劳动的装置突然导致了劳动者(特别是童工)工作时间令人震惊的上升。其次,节省劳动的机器本该压缩劳动者的数量,不过是以让工人失业的形式进行的。在这一事例中,我们的两难局面具有了另一种形式:如果价值源于劳动,假定劳动者越多,那么所生产的价值也就越多,可资本家为什么坚持压缩劳动者的数量?

在这一点上,整个过程的 真理也变得越来越清晰了,马克思将决定性地阐明他所谓“资本主义积累的一般规律”,即他在同一文本脉络中称之为“绝对”规律的东西。以下是我的引用:“社会的财富即执行职能的资本越大,它的增长的规模和能力越大,从而无产阶级的绝对数量和他们的劳动生产力越大,产业后备军也就越大。可供支配的劳动力同资本的膨胀力一样,是由同一些原因发展起来的。因此,产业后备军的相对量和财富的力量一同增长。”当我们记起这一正式的响亮的表达——“产业后备军”——仅仅指失业者的时候,我们就拥有了更具戏剧意味、更容易获得的辩证悖论。它仅仅意味着资本主义的绝对规律是:增加财富和生产力的同时,不断增加失业者的数量。

现在我们可以回过头来评 价整部《资本论》的意义了。这是一本关于失业的书:抵达《资本论》概念顶端的是以下命题,即产业资本主义一方面生产出数量巨大的资本——这种资本在潜在的意义上是无法投资的,另一方面制造出人数不断上升的失业人群。当前第三阶段资本主义或金融资本的危机可以充分证实这一情况。

并没有描绘社会主义的样子

我想补充的是,资本无关乎劳动:它关乎过度劳动,非人的过长的劳动时间以及前者被限定之后童工的大量产生都是例证。资本也与这一著名的“产业后备军”相关,也就是说,与失业者相关。这里并不涉及Harry Braverman论泰勒制、劳动与垄断资本的经典著作所指向的严格意义上的劳动。然而,以下想法是错误的:历史发展已使这一资本主义总体性的19世纪再现变得陈腐过时:正相反,从马克思的著作中凸显出来的资本的时刻,恰恰在未来的运动中得到了仔细的勾勒——这些空间一方面是信用和金融资本,另一方面是帝国主义(马克思自己关于帝国主义的描述只是简单地谈及诸如澳大利亚这样的移民殖民地,虽然你可以从这一论原始积累的尾声中推导出我们所谓的今日帝国主义)。

因此,我必须下这样一个 结论,《资本论》并不是一本政治著作,除了建议工人组织起来之外,它关于资本的说明并没有任何政治后果。除了在第一部分举了一个假想的例子——联合起来的工人社会——之外,它并没有描绘社会主义的样子。然而,让我更为充分地来解释一下:马克思是一个真正的政治人物,大概除了列宁之外,马克思所具有的杰出的政治本能与政治思考无人能及。他是一个非同寻常的机会主义者,这是马基雅维利意义上的良好的机会主义。为了改变和废除资本主义,他可以向任何可能的道路开放:联合、暴动、议会选举中获胜、回到农村公社,甚至是资本在危机中自我毁灭,等等。如今每一种政治性的马克思主义运动——从社会民主派到列宁主义、毛泽东主义和无政府主义——都是马克思整个方案的可行的候选者,而他的议程则是随历史情境和资本主义自身的发展而改变的。然而,在《资本论》里却没有任何政治方案或是政治策略,《资本论》依然是阿尔都塞意义上的科学而非意识形态。

人们常常哀叹马克思主义 似乎只是纯粹的经济理论,没有为合适的马克思主义政治理论留出足够的空间。而我却认为这正是马克思主义的力量,政治理论和政治哲学总是附带性的。政治只应该是永远警惕的机会主义的事务,却不是任何理论或哲学的事务。在我看来,甚至当前以种种方式重新定义大众民主的努力也偏离了资本主义的本性与结构这一核心议题。永远也没有令人满意的政治解答或政治体系,但是可以有更好的经济体系。马克思主义者和左派需要把精力放在后一方面。

后现代:空间正在消除时间

接下来,我想首先转向后现代性中的日常生活领域,也就是转向主体性构造领域以及某一尚属推测中的新的后现代主体领域。毋庸置疑,信息技术的出现——此种发展完全改造了工业生产甚至是劳动自身——必然会带来主体性的改变,主体醒着的时间完全消耗在各种类型的电脑显示器前了。

就主体性和个人经验而 言,我们对时间的经验正被替换为对空间的经验。可事实是,我们在自己的主观意识里、在现象学的经验和生存体验里都感受着时间的存在。因此,我们需要追问,为什么这种时间感却要屈从于空间的统摄?我想,不仅是柏格森,还有托马斯·曼和普鲁斯特,这些现代主义者都迷恋深度时间。这种迷恋实际上根源于现代化进程的不平衡,于是造成了迟缓的乡村时间和令人眼花缭乱的都市及工业化节奏共存的情况。因此我们说,后现代是现代化的完成,是乡村的消失的结果(农民成为计时工人,原始农业变成农业产业)。在更充分的现代化中,工业劳动力和城市资产阶级的区分都被抹去。每个人都是消费者,每个人都成为雇佣者,一切东西都进了购物中心,空间不过是表面的无限延展。现代化不平衡发展在过去是由区域和民族国家体制造成的,现在则是由全球化造成的,文化自身成为不平衡发展的一个空间。这样,和全球化的联系就十分清楚了:如此辽阔的全球规模绝不可能在以帝国主义、大都市和殖民为代表的现代阶段出现,只有当殖民体系解体了,它才有了出现的条件。

但是就今天的现实而言, 我们应该谈论的倒不是民族解放而是商业,不是一般的跨国公司,而是新的巨型国际商业集团出现所依赖的信息技术。在电脑化时代,空间的距离是如何正被翻译为实际存在时间的共时性的,也就是说,空间正在消除时间。投资、期货、廉价兜售国家货币、剥夺和并购,把未来打包作为可以买卖的商品,这些都被最新出现的交流工具加速实现着,柏格森主义所谓具有绵延特征的时间轨迹已荡然无存。时间的停滞严重地改变了或切割了人类的经验。

我将这称之为时间性的终 结,一切终止于身体和此刻。值得寻找的只是一个强化的现在,它的前后时刻都不再存在。我们的历史观也受到影响。从前的社会没有一个像我们现在的社会这样,有着如此少的功能性记忆和可怜的历史感。这一切和今天个人主体的转换干系重大。在后现代性第一次萌动中,结构主义和后结构主义者宣告了“主体的死亡”。他们看到资产阶级的个人主义因无法和庞大的体制力量抗衡而日趋衰落,同时也看到这种个人主义体现的是具有占有欲和侵略性的自我,而把这种自我唤起的资本主义竞争如今也已衰落。身体是资产阶级文化在消耗殆尽之前的最后现实,是转变、变化和变异的最后发生地,是主体的昂扬自信的激情消退后残留的一点点心情。

政治在本质上反映为掠夺土地

回头反思使我们看到,作为第三个资本主义阶段的全球化只是发生在20世纪60年代的激烈的反殖民运动另一个面向。资本主义在前两个阶段首先建立了民族工业和市场,随后进入帝国主义和抢占殖民地时期,并迅速发展了世界经济的殖民体系。这两个时期的一个共同标志是对他者的建构。首先是各式各样的民族国家把人民分成相互竞争的群体,人们的民族认同只能建立在对外国人和民族敌人的憎恨上,而各自的身份认同则通过相互指认为他者来完成。但是不久,特别是在欧洲,民族主义迅速放弃狭隘的民族立场,允许少数族裔和操不同语言的人发展自己的民族方案。

这种渐进的扩展不可与后 来的全球化相混淆。帝国主义体系是把殖民地的臣民当作他者来殖民的。种族的他者意识和充满欧洲中心主义或美国中心主义式的对落后的、贫弱的臣属文化的轻蔑将殖民地的人民视为前现代的人,将统治性文化和被统治文化区分开来。他者的世界体系就在作为第二个资本主义时期即帝国主义和现代性阶段建立起来了。

显然在反殖民运动中,这 一切都逐渐烟消云散了。臣属的他者们一向无权为自己辩护更不用说来管理自己了,现在则第一次如萨特所说,用自己的声音宣告自己存在的自由。一刹那,资产阶级主体和这些从前的他者们泯然一体了,整个世界被一种新的无名所统治。现在世界上存在的不仅仅是成千上万某个国家的公民,某个民族的语言,而是几十亿人。

那么这一切与政治是什么 关系呢?既然我们一直在讨论空间,我不妨就简单提出一个看法:今日之世界政治皆与房地产相关。后现代政治在本质上反映的是土地掠夺,在地区和全球范围都是如此。无论我们想到的是巴勒斯坦聚居地和难民营问题,还是原材料及其开发政策,或者生态问题,联邦制问题、公民权和移民问题,在大都市同时也在法国简易居住大棚、巴西贫民窟和小镇上发生的中产阶级化问题,今天的一切都和土地相关。按马克思主义术语说,这一切变化归于土地的商品化和残余的封建制以及农民阶层的消失,取而代之的是工业农业、农业商业以及农场工人。

那么时间去哪了?它在我们瞬间拥挤的手机电话和短信发射中,在西雅图、胜利广场和威斯康辛的群众游行人群里。这样的时间,正如我的朋友迈克·哈特和托尼·奈格里所说的,标志着乌合之众的出现。这已不是延绵时间里的政治,而就是此刻和现在的政治。奈格里让我们看到这种时间乃是一种构成性力量而不是被构成的力量。总而言之,这种新的此刻已成为后现代性的标识,一切都停留在此刻和身体里。在这新的无处不在的空间和短暂此刻的辩证法里,历史、历史性和对历史的感觉都成为失败者。过去已经不在,未来却无法憧憬。很显然,历史的消亡为我们的政治和政治实践罩上了阴沉的暗影。

PS: 留下邮箱的读者,可以收到[资本论].卡尔·马克思.全彩版书籍

spring security使用中的坑

跨域问题的解决办法Request header field Content-Type is not allowed by Access-Control-Allow-Headers in preflight response.

HTTP响应头

这部分里列出了跨域资源共享(Cross-Origin Resource Sharing)时,服务器端需要返回的响应头信息.上一部分内容是这部分内容在实际运用中的一个概述.Access-Control-Allow-Origin

返回的资源需要有一个Access-Control-Allow-Origin 头信息,语法如下:

[crayon-583580f1a3e67652606354/]

origin参数指定一个允许向该服务器提交请求的URI.对于一个不带有credentials的请求,可以指定为'*',表示允许来自所有域的请求.

举个栗子,允许来自 http://mozilla.com 的请求,你可以这样指定:

[crayon-583580f1a3e6d928912362/]

如果服务器端指定了域名,而不是'*',那么响应头的Vary值里必须包含Origin.它告诉客户端: 响应是根据请求头里的Origin的值来返回不同的内容的.

Access-Control-Expose-Headers

Requires Gecko 2.0(Firefox 4 / Thunderbird 3.3 / SeaMonkey 2.1)X-My-Custom-Header 和 X-Another-Custom-Header这两个头信息,都可以被浏览器得到.

Access-Control-Max-Age

这个头告诉我们这次预请求的结果的有效期是多久,如下: [crayon-583580f1a3e78715026637/]delta-seconds 参数表示,允许这个预请求的参数缓存的秒数,在此期间,不用发出另一条预检请求.

Access-Control-Allow-Credentials

告知客户端,当请求的credientials属性是true的时候,响应是否可以被得到.当它作为预请求的响应的一部分时,它用来告知实际的请求是否使用了credentials.注意,简单的GET请求不会预检,所以如果一个请求是为了得到一个带有credentials的资源,而响应里又没有Access-Control-Allow-Credentials头信息,那么说明这个响应被忽略了. [crayon-583580f1a3e7d747521262/] 带有credential的请求.Access-Control-Allow-Methods

指明资源可以被请求的方式有哪些(一个或者多个). 这个响应头信息在客户端发出预检请求的时候会被返回. 上面有相关的例子. [crayon-583580f1a3e82971546128/] 发出预检请求的例子见上,这个例子里就有向客户端发送Access-Control-Allow-Methods响应头信息.Access-Control-Allow-Headers

也是在响应预检请求的时候使用.用来指明在实际的请求中,可以使用哪些自定义HTTP请求头.比如 [crayon-583580f1a3e88420577400/] 这样在实际的请求里,请求头信息里就可以有这么一条: [crayon-583580f1a3e8d978073563/] 可以有多个自定义HTTP请求头,用逗号分隔. [crayon-583580f1a3e91756525726/]HTTP 请求头

这部分内容列出来当浏览器发出跨域请求时可能用到的HTTP请求头.注意这些请求头信息都是在请求服务器的时候已经为你设置好的,当开发者使用跨域的XMLHttpRequest的时候,不需要手动的设置这些头信息.Origin

表明发送请求或者预请求的域 [crayon-583580f1a3e97162202231/] 参数origin是一个URI,告诉服务器端,请求来自哪里.它不包含任何路径信息,只是服务器名.Access-Control-Request-Method

在发出预检请求时带有这个头信息,告诉服务器在实际请求时会使用的请求方式 [crayon-583580f1a3e9c428126084/]Access-Control-Request-Headers

在发出预检请求时带有这个头信息,告诉服务器在实际请求时会携带的自定义头信息.如有多个,可以用逗号分开. [crayon-583580f1a3ea1588455460/] 本文:http://www.paymoon.com:8001/index.php/2016/11/23/request-header-field-content-type-is-not-allowed-by-access-control-allow-headers-in-preflight-response/浏览器支持

| Feature | Chrome | Firefox (Gecko) | Internet Explorer | Opera | Safari |

|---|---|---|---|---|---|

| Basic support | 4 | 3.5 | 8 (via XDomainRequest) 10 | 12 | 4 |

注意:

Internet Explorer 8 和 9 通过 XDomainRequest 对象来实现CORS ,但是在IE 10中有完整的实现。Firefox 3.5 就引入了对跨站 XMLHttpRequests 和 Web 字体的支持 ,尽管存在着一些直到后续版本才取消的限制。特别的, Firefox 7 引入了对跨站 WebGL 纹理的 HTTP 请求的支持,而且 Firefox 9 添加对通过 drawImage 在 canvas 上绘图的支持。 相关参考: http://www.paymoon.com:8001/index.php/2016/05/30/java-web-support-cors-visit/ https://developer.mozilla.org/zh-CN/docs/Web/HTTP/Access_control_CORS#Access-Control-Allow-Origin http://stackoverflow.com/questions/16190699/automatically-add-header-to-every-response 本文:http://www.paymoon.com:8001/index.php/2016/11/23/request-header-field-content-type-is-not-allowed-by-access-control-allow-headers-in-preflight-response/[OS][分步式文件系统]什么是文件系统

| 表四 NTFS和FAT文件系统的比较 | |||

| 比较项 | NTFS | FAT16 | FAT32 |

| 操作系统兼容性 | 一 台运行Windows 2000或Windows XP Professional的机器可以访问NTFS分区上的文件。一台运行Windows NT 4.0(SP4或更高版本) 的机器可以访问该分区上的文件,但一些NTFS功能,例如磁盘配额就不可用了。其他操作系统不能访问。 | MSDOS、Windows的所有版本、Windows NT、Windows XP Professional、OS/2都可以访问。 | 只有在Windows 95 OSR2、Windows 98、Windows Me、Windows 2000以及Windows XP Professional下可以访问。 |

| 卷大小 | 推荐最小卷容量大约是10MB。 推荐实际最大卷容量是2TB。 您也可以使用更大的容量。 不能在软盘上使用。 | 卷最大为4GB。不能在软盘上使用。 | 卷大小从512MB到2TB。 在Windows XP Professional下,一个FAT32卷最大只能被格式化到32GB。 不能在软盘上使用。 |

| 文件大小 | 最大文件尺寸是16TB减去64KB(244减去64KB)。 | 最大文件尺寸为4GB。 | 最大文件尺寸为4GB。 |

| 每卷文件数 | 4,294,967,295 (232减1个文件)。 | 65,536 (216 个文件)。 | 大约4,194,304 (222个文件)。 |

[分布式计算]开发与实现(一)

介绍

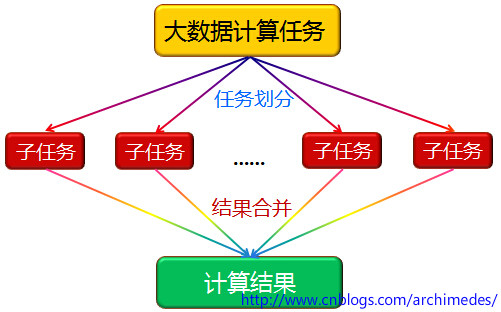

分布式计算简单来说,是把一个大计算任务拆分成多个小计算任务分布到若干台机器上去计算,然后再进行结果汇总。 目的在于分析计算海量的数据,从雷达监测的海量历史信号中分析异常信号(外星文明),淘宝双十一实时计算各地区的消费习惯等。 海量计算最开始的方案是提高单机计算性能,如大型机,后来由于数据的爆发式增长、单机性能却跟不上,才有分布式计算这种妥协方案。 因为计算一旦拆分,问题会变得非常复杂,像一致性、数据完整、通信、容灾、任务调度等问题也都来了。 举个例子,产品要求从数据库中100G的用户购买数据,分析出各地域的消费习惯金额等。 如果没什么时间要求,程序员小明就写个对应的业务处理服务程序,部署到服务器上,让它慢慢跑就是了,小明预计10个小时能处理完。 后面产品嫌太慢,让小明想办法加快到3个小时。 平常开发中类似的需求也很多,总结出来就是,数据量大、单机计算慢。 如果上Hadoop、storm之类成本较高、而且有点大才小用。 当然让老板买更好的服务器配置也是一种办法。利用分片算法

小明作为一个有追求有理想的程序员,决定用介于单机计算和成熟计算框架的过度解决方案,这样成本和需求都能满足了。 分布式计算的核心在于计算任务拆分,如果数据能以水平拆分的方式,分布到5台机器上,每台机器只计算自身的1/5数据,这样即能在3小时内完成产品需求了。 如上所述,小明需要把这些数据按照一定维度进行划分。 按需求来看以用户ID划分最好,由于用户之间没有状态上的关联,所以也不需要事务性及二次迭代计算。 小明用简单的hash取模对id进行划分。利用消息队列

使用分片方式相对比较简单,但有如下不足之处。- 它不具有负载均衡的能力,如果某台机器配置稍好点,它可能最先计算完,然后空闲等待着。也有可能是某些用户行为数据比较少,导致计算比较快完成。

- 还有一个弊端就是每台机器上需要手动更改对应的配置, 这样的话多台机器上的程序不是完全一样的,这样可以用远程配置动态修改的办法来解决。

- 推送消息的,简称Master。

- 消息队列,这里以Rabbitmq为例。

- 各个处理程序,简称Worker或Slave都行。

- 计算任务分发。 Master把需要计算的用户数据,不断的推送消息队列。

- 程序一致性。 Worker订阅相同的消息队列即可,无需更改程序代码。

- 任意扩容。 由于程序完全一样,意味着如果想要加快速度,重复部署一份程序到新机器即可。 当然这是理论上的,实际当中会受限于消息队列、数据库存储等。

- 容灾性。 如果5台中某一台程序挂了也不影响,利用Rabbitmq的消息确认机制,机器崩溃时正在计算的那一条数据会在超时,在其他节点上进行消费处理。

Hadoop简介

Hadoop介绍已经相当多了,这里简述下比如:"Hadoop是一套海量数据计算存储的基础平台架构",分析下这句话。- 其中计算指的是MapReduce,这是做分布式计算用的。

- 存储指的是HDFS,基于此上层的有HBase、Hive,用来做数据存储用的。

- 平台,指可以给多个用户使用,比如小明有一计算需求,他只需要按照对应的接口编写业务逻辑即可,然后把程序以包的形式发布到平台上,平台进行分配调度计算等。 而上面小明的分布式计算设计只能给自己使用,如果另外有小华要使用就需要重新写一份,然后单独部署,申请机器等。Hadoop最大的优势之一就在于提供了一套这样的完整解决方案。

- 图中“大数据计算任务” 对应小明的100G用户数据的计算任务。

- ”任务划分“ 对应Master和消息队列。

- “子任务” 对应Worker的业务逻辑。

- ”结果合并“ 对应把每个worker的计算结果入库。

- “计算结果” 对应入库的用户消费习惯数据。

PS:为了方便描述,把小明设计的分布式计算,叫做小和尚。

PS:为了方便描述,把小明设计的分布式计算,叫做小和尚。

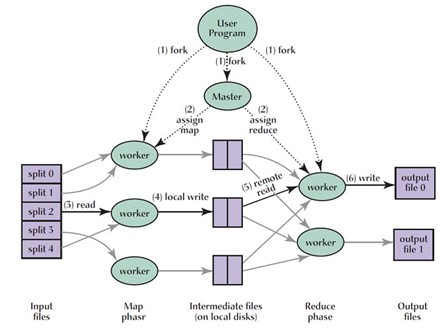

MapReduce

由于MapReduce计算输入和输出都是基于HDFS文件,所以大多数公司的做法是把mysql或sqlserver的数据导入到HDFS,计算完后再导出到常规的数据库中,这是MapReduce不够灵活的地方之一。 MapReduce优势在于提供了比较简单的分布式计算编程模型,使开发此类程序变得非常简单,像之前的MPI编程就相当复杂。 狭隘的来讲,MapReduce是把计算任务给规范化了,它可以等同于小和尚中Worker的业务逻辑部分。 MapReduce把业务逻辑给拆分成2个大部分,Map和Reduce,可以先在Map部分把任务计算一半后,扔给Reduce部分继续后面的计算。 当然在Map部分把计算任务全做完也是可以的。 关于Mapreduce实现细节部分不多解释,有兴趣的同学可以查相关资料或看下楼主之前的C#模拟实现的博客【探索C#之微型MapReduce】。 如果把小明产品经理的需求放到Hadoop来做,其处理流程大致如下:- 把100G数据导入到HDFS

- 按照Mapreduce的接口编写处理逻辑,分Map、Reduce两部分。

- 把程序包提交到Mapreduce平台上,存储在HDFS里。

- 平台中有个叫Jobtracker进程的角色进行分发任务。 这个类似小和尚的Master负载调度管理。

- 如果有5台机器进行计算的话,就会提前运行5个叫TaskTracker的slave进程。 这类似小和尚worker的分离版,平台把程序和业务逻辑进行分离了, 简单来说就是在机器上运行个独立进程,它能动态加载、执行jar或dll的业务逻辑代码。

- Jobtracker把任务分发到TaskTracker后,TaskTracker把开始动态加载jar包,创建个独立进程执行Map部分,然后把结果写入到HDFS上。

- 如果有Reduce部分,TaskTracker会创建个独立进程把Map输出的HDFS文件,通过RPC方式远程拉取到本地,拉取成功后,Reduce开始计算后续任务。

- Reduce再把结果写入到HDFS中

- 从HDFS中把结果导出。

离线计算

通常称Mapreduce及小和尚这种计算为离线计算,因为它对已经持久化的文件数据进行计算,不能实时响应。 还有个原因就是它的处理速度比较慢,它的输入和输出源都是基于HDFS设计,如果数据不是一开始就写入到HDFS上,就会涉及到数据导入导出,这部分相对耗费时间。 而且它的数据流动是基于文件系统的,Map部分输出的数据不是直接传送到Reduce部分,而是先写入HDFS再进行传送。 处理速度慢也是Mapreduce的不足之处,促使了后面实时计算的诞生。 另外个缺点是Mapreduce的计算任务流比较单一,它只有Map、Reduce两部分。 简单的可以只写一部分逻辑来解决,如果想拆分成多个部分,如逻辑A、逻辑B、逻辑C等, 而且一部分计算逻辑依赖上一次计算结果的话,MapReduce处理起来就比较困难了。 像storm框架解决此类问题的方案,也称为流式计算,下一章继续补充。

[分布式计算]开发与实现(二)

实时计算

接上篇,离线计算是对已经入库的数据进行计算,在查询时对批量数据进行检索、磁盘读取展示。 而实时计算是在数据产生时就对其进行计算,然后实时展示结果,一般是秒级。 举个例子来说,如果有个大型网站,要实时统计用户的搜索内容,这样就能计算出热点新闻及突发事件了。 按照以前离线计算的做法是不能满足的,需要使用到实时计算。 小明作为有理想、有追求的程序员开始设计其解决方案了,主要分三部分。- 每当搜索内容的数据产生时,先把数据收集到消息队列,由于其数据量较大,以使用kafka为例。 这个收集过程是一直持续的,数据不断产生然后不断流入到kafka中。

- 要有一个能持续计算的框架,一旦收集到数据,计算系统能实时收到数据,根据业务逻辑开始计算,然后不断产生需要的结果,这里以storm为例。

- 根据结果进行实时展示并入库, 可以一边展示一边入库,对外提供实时查询的服务。这里的入库可以是基于内存的Redis、MongoDB,也可是基于磁盘的HBase、Mysql、SqlServer等。

storm简介

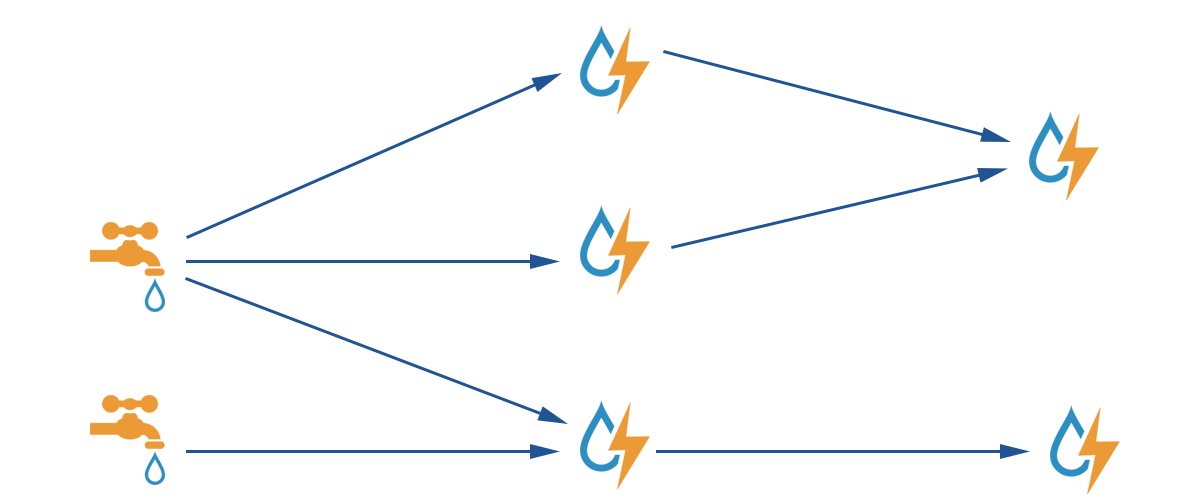

通常都介绍Storm是一个分布式的、高容错的实时计算系统。 “分布式”是把数据分布到多台上进行计算,“高容错”下面谈,这里主要细节介绍下“实时计算”的实现。 storm有个角色叫topology,它类似mapreduce的job,是一个完整的业务计算任务抽象。 上章谈到hadoop的缺点在于数据源单一依赖HDFS,storm中Spout角色的出现解决了这个问题。 在Spout内部我们可以读取任意数据源的数据,比如Redis、消息队列、数据库等等。 而且spout可以是多个,这样更好的分类,比如可以SpoutA读取kafka,SpoutB读取Redis。 示例如下:流式计算

主流的流式计算有S4、StreamBase、Borealis,其storm也具有流式计算的特性。 流式计算是指“数据能像液体水一样不断的在各个节点间流动,每个节点都可以对“数据(液体水)”进行计算,然后产生新的数据,继续像水一样流动”。如图: 图中Spout就是水龙头,它不断的通过NextData产生数据,然后流动各个Bolt中。 Bolt是各个计算节点上的计算逻辑,它拿到数据后开始计算,完成后流向另外一个,直到完成。 其Bolt也可以是任意个,这比Mapreduce只能分成Map、Reduce两部分好多了。 这样可以在BlotA中计算中间值,然后通过这个中间值去任意数据源拉取数据后,在流动到下一步处理逻辑中, 这个中间值直接在内存中,通过网络流动BlotB上。 其大大增加了其适用范围和灵活度,Spout和bolt的数据流动构成了一个有向无环图。 Bolt示例代码如下。

图中Spout就是水龙头,它不断的通过NextData产生数据,然后流动各个Bolt中。 Bolt是各个计算节点上的计算逻辑,它拿到数据后开始计算,完成后流向另外一个,直到完成。 其Bolt也可以是任意个,这比Mapreduce只能分成Map、Reduce两部分好多了。 这样可以在BlotA中计算中间值,然后通过这个中间值去任意数据源拉取数据后,在流动到下一步处理逻辑中, 这个中间值直接在内存中,通过网络流动BlotB上。 其大大增加了其适用范围和灵活度,Spout和bolt的数据流动构成了一个有向无环图。 Bolt示例代码如下。

归纳总结

结合上篇,发现Hadoop离线计算的计算要求是把业务逻辑包上传到平台上,数据导入到HDFS上,这样才能进行计算。 其产生的结果数据是展示之前就计算好的,另外它的计算是按批次来的,比如很多公司的报表,都是每天凌晨开始计算前一天的数据,以便于展示。 其数据是不动的,计算逻辑也是不动的。 Storm的流式计算同样是把计算逻辑包上传到平台上,由平台调度,计算逻辑是不动的。 但数据可以是任意来源的,不断在计算节点进行流动。 也即是说在数据产生的时刻,就开始进行流动计算,它展示的结果数据是实时变化的。 其数据是流动的,计算逻辑是不动的。storm把产生的每条数据当成一个消息来处理,其内部也是通过消息队列组件zeromq来完成的。高容错性

storm提供了各级别的可靠性保证,一消息从Spout流动到boltA,在流动boltB, 那storm会通过唯一值不断异或的设计去监测这个消息的完成情况,这个监测是一个和业务逻辑类似的bolt,不过它是有storm自身实现的,叫Acker,它的任务就是接收各个消息任务的完成状态,然后告诉Spout这个消息是否已经完全处理。下面是几种异常处理情况:- BoltB所在的节点挂了或消息异常,那么这条消息就没有处理完,Spout可在超时后重新发射该数据即可。

- Acker所在节点挂了后,即当前节点监控的消息完全情况,会全部丢失,Spout会在消息超时做后续处理。

- 如果Spout所在节点挂了,那Spout发射的数据也会全部丢失, 这时可在消息队列中设置超时时间,如果没有一直没对消息进行Ack的话,那么这条消息会重新让其他的Spout重新接收到。这部分需要单独在消息队列中配置,另外storm消息的Ack确认对性能有一定影响,可根据消息的重要性是否要开启它。

- 如果storm平台级别的组件挂了,平台会尝试重启失败的组件,storm除nimbus组件外都是多节点点部署,挂了某一节点,不会对任务计算有所影响。

[ssh what ] SSH4是什么

这里简单翻译了下官方对SS4的定位和说明:

Spring Security为J2EE企业级应用提供了全面的安全服务。

应用级别的安全主要分为“验证( authentication) ”和“(授权) authorization ”两个部分。这也是Spring Security主要需要处理的两个部分。“ Authentication ”指的是建立规则( principal )的过程。规则可以是一个用户、设备、或者其他可以在我们的应用中执行某种操作的其他系统。" Authorization "指的是判断某个 principal 在我们的应用是否允许执行某个操作。在 进行授权判断之前,要求其所要使用到的规则必须在验证过程中已经建立好了。这些概念是通用的,并不是只针对"Spring Security"。

在验证(Authentication )层面, Spring Security 提供了不同的验证模型。大部分的authentication模型来自于第三方或者权威机构或者由一些相关的标准制定组织(如IETF)开发。此外,Spring Security也提供了一些验证特性。特别的,Spring Security目前支持对多种验证方式的整合:

除了验证机制, Spring Security 也提供了一系列的授权能力。主要感兴趣的是以下三个方面:

1、对web请求进行授权

2、授权某个方法是否可以被调用

3、授权访问单个领域对象实例

Reference:

官方介绍 http://docs.spring.io/spring-security/site/docs/current/reference/htmlsingle/[ss4]why 为什么使用Spring Security 4

同比

必须用吗/有同类吗?

当然不是绝对,不使用框架的话,完全可以自己定义扮演各作用的filter,在filter里面做认证,授权,页面显示用标签之类控制,

我先贴上一段官方的推荐:

人们使用 Spring Security的原因有很多,但是大部分项目是发现 Java EE的Servlet 规范或者EJB规范对企业级应用场景提供的安全特性不够深入。提到这些规范,要认识到的一点是,在war包或者ear包的级别上,这些安全机制是不可以移植的。意思就是,如果我们使用了不同的服务器环境,我们通常需要为新的服务器环境重新配置或者开发系统的安全机制。使用Spring Security可以克服这些问题,并且可以给你带来大量的其他有用的、可以自定义的特性。

官方说了三点,一是深入,二是可移植,还可以自定义。

官方说的我和Shiro比较了下,刚才在介绍权限的实现中,我们有提到,除了SS4,也有其它的实现,如Apache Shiro

两者比较为:SS4除了不能脱离Spring,shiro的功能SS4都有。而且Spring Security对Oauth、OpenID也有支持, Shiro则需要自己手动实现。Spring Security的权限细粒度更高

个人在使用中的体验:在认识Spring Security之前,所有的权限验证逻辑都混杂在业务逻辑中,用户的每个操作以前可能都需要对用户是否有进行该项操作的权限进行判断,来达到认证授权的目的。类似这样的权限验证逻辑代码被分散在系统的许多地方,难以维护

也有缺点:

现在的SpringSecurity filter多,配置项多,有些地方需要查,有一定的学习成本。

总结:选择哪个根据自己的业务来定,单就Spring Security的话,掌握的话用起来挺方便的,尤其想做细粒度的控制的话,Spring Security考虑的比较全面,和Spring结合有优势。

说完了SS4的同比优缺点,再说下单就Spring Security的好处。

单就Spring Security的好处

因为 Spring Security 基于Spring的企业应用系统提供声明式的安全访问控制解决方案的安全框架。

它提供了一组可以在Spring应用上下文中配置的Bean,充分利用了Spring IoC,DI(控制反转Inversion of Control ,DI:Dependency Injection 依赖注入)和AOP(面向切面编程)功能,为应用系统提供声明式的安全访问控制功能,减少了为企业系统安全控制编写大量重复代码的工作

可以总结为:轻量<大小,开销,非侵入>,有背景<Spring容器,易开发,AOP,IoC等特性>

why 4 not 3?

除了3的功能4都有外,还修复了很多关键性的bug,以及增加了相当多的特性如SCRF, 并且有些语法两者不兼容,考虑以后长远的使用,所以以4为中心。

[ss4][权限]用户认证与授权过程

1)、安全包括认证授权两个主要操作。

“认证”是为用户建立一个他所声明的主体。主体一般是指用户,设备或可以在你系统中执行行动的其他系统。

“授权”指的一个用户能否在你的应用中执行某个操作。在到达授权判断之前,身份的主体已经由身份验证过程建立了。

用户认证过程<过程见[权限]权限的原理如刚才的流程图>

1.点击一个链接访问一个网页;

2.浏览器发送一个请求到服务器,服务器判断出你正在访问一个受保护的资源;

3.如果此时你并未通过身份认证,服务器发回一个响应提示你进行认证——这个响应可能是一个HTTP响应代码,抑或重定向到一个指定页面;

4.根据系统使用认证机制的不同,浏览器或者重定向到一个登录页面中,或者由浏览器通过一些其它的方式获取你的身份信息(如通过BASIC认证对话框、一个Cookie)

5.浏览器再次将用户身份信息发送到服务器上(可能是一个用户登录表单的HTTP POST信息、也可能是包含认证信息的HTTP报文头);

6.服务器判断用户认证信息是否有效,如果无效,一般情况下,浏览器会要求你继续尝试,这意味着返回第3步。如果有效,则到达下一步;

7.服务器重新响应第2步所提交的原始请求,并判断该请求所访问的程序资源是否在你的权限范围内,如果你有权访问,请求将得到正确的执行并返回结果。否则,你将收到一个HTTP 403错误,这意味着你被禁止访问。

用户授权过程<见[权限]权限的原理>

[SS4层面]SS4是如何把权限实现的原理

认证

用户登陆,会被AuthenticationProcessingFilter拦截,调用AuthenticationManager的实现,而且AuthenticationManager会调用ProviderManager来获取用户验证信息(用户信息获取下面会讲),如果验证通过后会将用户的权限信息封装一个User放到spring的全局缓存SecurityContextHolder中,以备后面访问资源时使用。

而验证通过的过程,

通过从AuthenticationProcessingFilter,我们不难找到过滤器实现具体类<之后会讲SS4加载过程>UsernamePasswordAuthenticationFilter:

GenericFilterBean

AbstractAuthenticationProcessingFilter

下的UsernamePasswordAuthenticationFilter<过滤器实现具体类>

本文http://www.paymoon.com:8001/index.php/2016/12/07/how-ss4-apply-the-permission/ 如果转载请联系i@paymoon.com如图:

SecurityAuthenticationFilter就是自己实现了UsernamePasswordAuthenticationFilter的过滤器,

我们通过UsernamePasswordAuthenticationFilter类和其父类,也会到

private String usernameParameter = "username";

private String passwordParameter = "password";

最终我们通过successfulAuthentication方法,找到了AbstractAuthenticationProcessingFilter

AuthenticationSuccessHandler<认证成功后跳转>

AuthenticationFailureHandler<失败后跳转>

本文http://www.paymoon.com:8001/index.php/2016/12/07/how-ss4-apply-the-permission/ 如果转载请联系i@paymoon.com授权

Spring Security称受保护的应用资源为“安全对象”,这包括URL资源和业务类方法。spring AOP中有前置advice(处理、拦截器、通知)、后置advice 、异常advice和环绕advice 。Acegi使用环绕advice对安全对象进行保护。 Acegi通AbstractSecurityInterceptor为安全对象访问提供一致的工作模型,它按照以下流程进行工作:

1. 从SecurityContext中取出已经认证过的Authentication(包括权限信息);

2. 通过反射机制,根据目标安全对象和“配置属性”得到访问目标安全对象所需的权限;

3. AccessDecisionManager根据Authentication的授权信息和目标安全对象所需权限做出是否有权访问的判断。如果无权访问,Acegi将抛出AccessDeniedException异常,否则到下一步;

4. 访问安全对象并获取结果(返回值或HTTP响应);

5. AbstractSecurityInterceptor可以在结果返回前进行处理:更改结果或抛出异常。

本文http://www.paymoon.com:8001/index.php/2016/12/07/how-ss4-apply-the-permission/ 如果转载请联系i@paymoon.com